Pourquoi notre utilisation de l’intelligence artificielle est un gouffre énergétique

Par Léa Prati et Romain Geoffroy

hier à 05h00, modifié hier à 22h01 https://www.lemonde.fr/les-decodeurs/article/2025/06/08/pourquoi-notre-utilisation-de-l-ia-est-un-gouffre-energetique_6611132_4355770.html

Décryptage

De la conception d’un modèle à son utilisation, l’IA générative s’avère extrêmement énergivore. « Le Monde » détaille les raisons de cette voracité, alors que les usages sont en pleine expansion.

« Nos serveurs fondent. (…) Nous allons devoir introduire certaines limites. » Deux jours après avoir intégré une nouvelle option de génération d’images à ChatGPT, le 25 mars, le patron d’OpenAI, Sam Altman, ne cachait pas être dépassé. En cause, l’engouement suscité par la possibilité de transformer, grâce à l’intelligence artificielle (IA), des photos dans des styles différents, et particulièrement dans le style du Studio Ghibli, du producteur de films d’animation japonais Hayao Miyazaki. Annonçant 1 million d’inscriptions supplémentaires en une heure le 31 mars, Sam Altman reconnaît le lendemain faire face à des risques de ralentissement de ChatGPT, voire des pannes.

Lire aussi | Article réservé à nos abonnés Pourquoi les images de ChatGPT imitant le Studio Ghibli font polémique

Cet épisode met en lumière le gouffre énergétique que représente l’IA générative. Son développement effréné devrait plus que doubler la demande d’électricité des centres de données dans le monde d’ici à 2030. Selon un rapport publié en avril par l’Agence internationale de l’énergie (AIE), elle devrait atteindre environ 945 térawattheures, soit plus de la consommation totale d’électricité du Japon. A cette échéance, les centres de données consommeront un peu moins de 3 % de l’électricité mondiale, note l’agence. « Aux Etats-Unis, les centres de données représentent près de la moitié de la croissance attendue de la demande d’électricité d’ici à 2030 », prédit l’AIE.

Les projets de data center s prolifèrent outre-Atlantique. Dévoilé par Donald Trump, Stargate comprend une enveloppe de 500 milliards de dollars (441 milliards d’euros) de fonds publics et privés et prévoit jusqu’à 10 nouveaux centres de données. Preuve que l’énergie est au centre du développement de l’IA, Meta et Microsoft envisagent de relier leurs centres de données directement à des centrales nucléaires. Ces projets anticipent le succès annoncé de l’IA dans les années à venir. Désormais intégrés à Bing, WhatsApp et bientôt Google, ces modèles seront partout dans nos téléphones, soulevant des questions majeures en matière d’impact écologique.

Lire aussi | Article réservé à nos abonnés Data centers et intelligence artificielle : la course au gigantismeLire plus tard

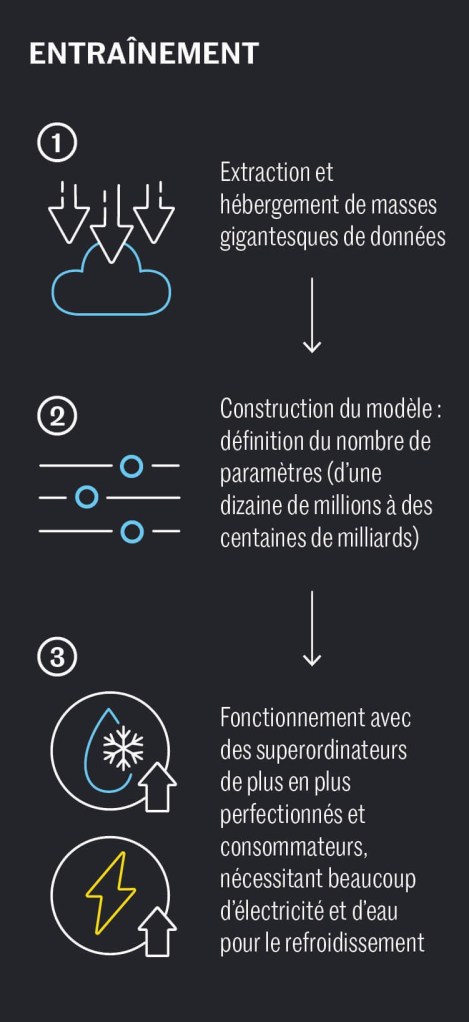

De l’entraînement à la requête

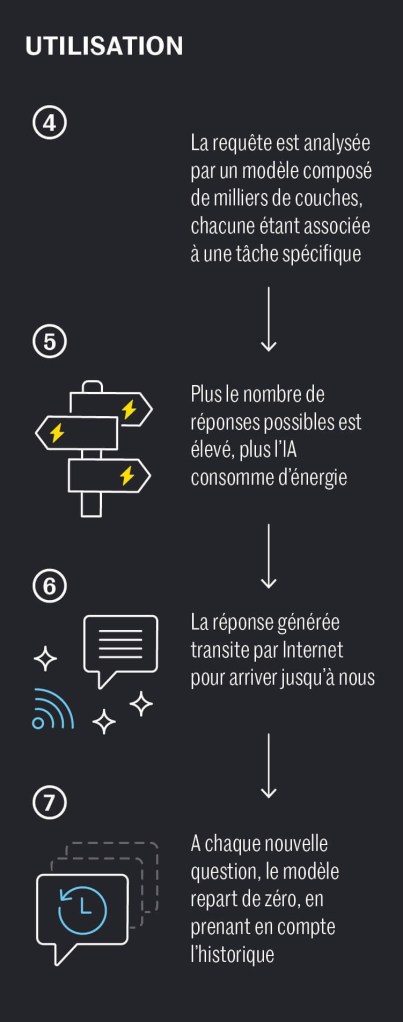

Mais alors pourquoi l’IA générative est-elle davantage énergivore que les technologies grand public que nous utilisions jusqu’alors ? Pour y répondre, il faut d’abord comprendre les deux phases du fonctionnement de ces robots : l’entraînement du modèle, puis l’inférence, c’est-à-dire son utilisation au quotidien.

La phase d’entaînement nécessite de rassembler des volumes massifs de données. L’IA générative apprend en ingurgitant : un modèle de texte (comme GPT) est nourri de livres, d’articles, de sites web ; un modèle d’image, comme DALL-E, doit avaler des millions d’images légendées. Une fois cette base de données constituée et nettoyée, on crée un réseau de neurones, inspiré du cerveau humain : un cerveau artificiel encore vide, sans souvenirs, qui ne sait rien au départ. Il va alors apprendre par essais, en faisant des erreurs. On lui soumet des phrases ou images partiellement masquées, et on lui demande de prédire ce qui manque.

A chaque erreur, l’IA ajuste automatiquement ses calculs grâce à un mécanisme appelé rétropropagation, qui lui permet de corriger ses connexions internes et de progresser. Ce processus est particulièrement long et coûteux : selon les estimations, l’entraînement du GPT-4 d’OpenAI a coûté plus de 100 millions de dollars et consommé 50 gigawattheures d’énergie, soit suffisamment pour alimenter Paris pendant près de deux jours.

Depuis la démocratisation de l’accès à l’IA générative, avec le lancement de ChatGPT en 2022, son entraînement semble désormais moins problématique que son utilisation massive. « Avant cela, de grands modèles existaient déjà mais leurs usages restaient restreints aux seuls domaines de la recherche et de l’ingénierie », explique Valentin Goujon, spécialiste de l’intelligence artificielle et doctorant en sociologie au Medialab de Sciences Po. De 100 millions d’utilisateurs hebdomadaires fin 2023, ChatGPT aurait atteint les 400 millions en février 2025 pour doubler de taille en quelques mois, avec 800 millions d’utilisateurs actifs par semaine en avril, selon son fondateur.

Un article présenté en 2023 par les scientifiques Sasha Luccioni, Emma Strubell et Yacine Jernite s’est pour la première fois penché de manière sérieuse sur le coût de l’utilisation de ces IA, montrant que les milliards de requêtes (aussi appelées « prompt » en anglais) envoyées chaque jour pouvaient in fine rattraper le coût énergétique et carbone de l’entraînement d’un grand modèle de langage.0Nombre d’utilisateursInférenceEntraînement du modèleCoût énergétique

Toutes les requêtes n’impliquent pas le même niveau de complexité, ni la même dépense énergétique. Un facteur déterminant réside dans la taille des modèles, c’est-à-dire le nombre de paramètres qu’il contient : plus ceux-ci sont nombreux, plus le modèle gagne en performance, au prix d’une consommation énergétique accrue.

Classer, générer un texte, le résumer… Les besoins en calcul varient également selon la nature des tâches réalisées. Certains modèles, dits spécialisés, se concentrent sur des fonctions précises, comme la classification d’avis en ligne. A l’inverse, les modèles dits généralistes, les plus prisés du grand public, sont censés pouvoir répondre à toutes sortes de requêtes. Ils doivent « pouvoir produire des pixels tout comme du texte en anglais ou en français », décrypte Sasha Luccioni, responsable de l’IA et du climat pour la start-up Hugging Face. Or, « le problème c’est que ces modèles consomment 20 à 30 fois plus d’énergie qu’un petit modèle n’ayant qu’une seule tâche ».

Mais comment peut-on calculer précisément le coût énergétique d’une requête ? Chaque interaction avec une IA générative mobilise un ensemble de matériels et d’infrastructures :

- une série de composants informatiques comme la carte graphique (GPU), le processeur (CPU), la mémoire vive (RAM), le stockage, le réseau ;

- un centre de données dont le bâtiment regroupe des milliers de serveurs ;

- les « frais généraux » qui englobent la climatisation, le refroidissement des serveurs, l’alimentation de secours en cas de panne d’électricité

Vous pouvez partager un article en cliquant sur les icônes de partage en haut à droite de celui-ci.

La reproduction totale ou partielle d’un article, sans l’autorisation écrite et préalable du Monde, est strictement interdite.

Pour plus d’informations, consultez nos conditions générales de vente.

Pour toute demande d’autorisation, contactez syndication@lemonde.fr.

En tant qu’abonné, vous pouvez offrir jusqu’à cinq articles par mois à l’un de vos proches grâce à la fonctionnalité « Offrir un article ».

Le nœud du problème est qu’il est encore difficile de connaître parfaitement la consommation énergétique d’une requête. « Aucune compagnie de la Big Tech n’a voulu évaluer leur modèle parce que ce n’est éventuellement pas de la très bonne presse pour eux », déplore Sasha Luccioni. Les plus grosses entreprises du secteur cultivent l’opacité en la matière.

Consommation des modèles d’IA par type de tâches

Classification d’imagesSimilarité de phrasesDétection d’objetsClassification de textesRésuméReconnaissance de paroleRéponse à une questionSous-titrageGénération de textesGénération d’images0,01 Wh1 Wh100 Wh10 000 Wh

Source : AI Energy score

Consommation des modèles d’IA par type de tâches

Classification d’imagesSimilarité de phrasesDétection d’objetsClassification de textesRésuméReconnaissance de paroleRéponse à une questionSous-titrageGénération de textesGénération d’images0,01 Wh1 Wh100 Wh10 000 Wh

Ce manque de transparence des grands acteurs de la tech ne date pas d’hier. Il est aujourd’hui quasiment impossible d’obtenir des informations sur le coût énergétique d’une recherche Google. Seule miette laissée par l’entreprise, une estimation de 0,3 Wh par recherche en ligne donnée en 2009 dans une note de blog des dirigeants. Des chiffres totalement invérifiables, et probablement périmés, qui ne permettent pas aujourd’hui de comparer une recherche IA à une recherche classique sur le Web.

Derrière le gouffre énergétique de l’IA, un fort impact écologique

Avec son projet Ecologits, l’association GenAI Impact veut pousser les entreprises de l’IA à être plus transparentes sur leur empreinte écologique. « On propose aux utilisateurs de tester l’impact environnemental de chaque prompt selon le modèle utilisé, et même si c’est une estimation ça permet d’avoir un ordre de grandeur », justifie Samuel Rincé, cofondateur de l’association. Ecrire un tweet ou un rapport de cinq pages avec le modèle 4o de Chatgpt n’aura pas le même coût pour la planète que de le faire avec le dernier modèle de Mistral ou de Meta.

Lire aussi | Article réservé à nos abonnés La part d’ombre des intelligences artificielles qui se disent « open source »Lire plus tard

Le développement et l’utilisation massive de modèles plus importants, dont beaucoup sont alloués à la génération d’images ou de vidéos, vont de pair avec la multiplication des centres de données, loin d’être alimentés par des « énergies propres ». L’exigence de disponibilité permanente rend particulièrement complexe le recours exclusif à des énergies renouvelables comme l’éolien ou le solaire, dont la production reste intermittente et dépendante des conditions météorologiques. « Les services de Google ne s’éteignent pas quand il n’y a pas de soleil en Californie », illustre Anne-Laure Ligozat, professeure en informatique au Laboratoire interdisciplinaire des sciences du numérique (LISN).

Une récente étude menée par des chercheurs d’Harvard et de UCLA, disponible en preprint, non encore relue par leurs pairs, montre que 95 % des data centers américains sont construits dans des zones où les sources d’électricité sont plus polluantes que la moyenne américaine. L’intensité carbone des centres de données (quantité de CO₂ émise par unité d’électricité consommée) dépassait de 48 % la moyenne américaine. De nombreux centres de données ayant assez de cartes graphiques pour faire fonctionner des modèles comme GPT ou LLaMA (Meta), sont situés dans des régions productrices de charbon comme la Virginie, qui ne concentre pas moins de 300 data centers, selon les chercheurs. Dans les régions concentrant le plus de data centers aux Etats-Unis, plus de 56 % de l’électricité provient des énergies fossiles (essentiellement gaz et charbon), 21 % viennent du nucléaire et 22 % d’énergie renouvelable.

« La concentration des centres de données dans les mêmes régions pose des problèmes importants aux réseaux locaux en raison de leur consommation d’énergie considérable », alerte l’Agence internationale de l’énergie. Cette pression s’ajoute à d’autres conséquences environnementales, liées notamment à l’extraction des ressources minérales pour fabriquer les serveurs, à la consommation d’eau pour refroidir les data centers, et à l’occupation des sols. Autant de facteurs qui suscitent déjà des tensions. « Des conflits locaux sont déjà apparus, sur l’électricité comme sur l’eau, et cela pourrait bien s’amplifier », prévient Anne-Laure Ligozat.

Méthodologie

Pour évaluer l’empreinte environnementale de nos deux premiers cas d’usage, nous avons utilisé Ecologits, un outil développé par l’association GenAI Impact, qui propose un intervalle de consommation énergétique en KwH (seuil bas et haut) pour une requête spécifique. Son fonctionnement repose sur une méthodologie d’analyse du cycle de vie (ACV) conforme à la norme ISO 14044, appliquée aux tâches d’inférence des modèles d’IA générative et qui n’inclut donc pas l’entraînement, dont le coût environnemental tend à baisser à mesure que le nombre d’utilisateurs augmente.

L’approche adoptée est dite ascendante, permettant une estimation des impacts liés à chaque composant du service. Ecologits prend en compte plusieurs dimensions environnementales dont le potentiel de réchauffement climatique, l’épuisement des ressources abiotiques, la consommation d’énergie primaire. L’outil intègre également des hypothèses sur le mix énergétique mondial et considère partiellement les conséquences liées au recyclage. Toutefois, il semble important de mentionner que l’ensemble des résultats repose sur des estimations, en raison du manque de données ouvertes et de la nature propriétaire des modèles évalués, comme GPT-4o-mini utilisé ici, équivalent à celui proposé gratuitement par OpenAI.

Pour le troisième cas d’usage, l’outil Ecologits n’embarquant par la génération d’image, nous nous sommes basés sur le leaderboard AI Energy Score, initiative développée dans le cadre du sommet de l’IA à Paris en février 2025. Il est le fruit d’une collaboration entre Hugging Face, Salesforce, Méta, Cohere et l’Université Carnegie Mellon (Pennsylvanie). L’outil établit une approche standardisée pour évaluer l’efficacité énergétique de différentes tâches sur des modèles d’IA, dont la génération d’images. Léa PratiRomain Geoffroy