« Quelle éthique pour l’utilisation de l’intelligence artificielle dans la santé ? »

Date de publication : 10 janvier 2023

Soline Roy fait savoir dans Le Figaro que « le Comité national d’éthique publie un avis sur les questions posées par l’utilisation de l’IA pour le diagnostic médical ».

La journaliste note ainsi : « Identifier en un éclair un AVC sur un scanner cérébral. Prévoir le risque suicidaire en analysant des conversations sur un réseau social. Déceler une maladie de Parkinson débutante grâce à un changement de démarche. Dépister un cancer du poumon à un stade ultra-précoce… ».

« Les promesses de l’intelligence artificielle (IA) sont nombreuses, et elle en remplit déjà beaucoup à toutes les étapes du soin, de la conception des médicaments au suivi post-traitement en passant par le dépistage et le diagnostic. Mais à l’aube d’une révolution médicale qui nous propose de mettre notre santé aux mains des machines, les questions soulevées sont nombreuses. Et en particulier les questions éthiques », remarque-t-elle.

https://www.ccne-ethique.fr/sites/default/files/2021-09/Manifeste%20CNPEN.pdf

Soline Roy explique ainsi que « le Comité national pilote d’éthique du numérique (CNPEN), sous l’égide du Comité consultatif national d’éthique (CCNE), rend public ce mardi un avis sur les enjeux liés à l’utilisation de l’intelligence artificielle dans le domaine du diagnostic médical. Des enjeux «hétérogènes, voire parfois contradictoires, alertent les experts, entre intérêts économiques et industriels, promesses thérapeutiques pour les patients, modification de la pratique professionnelle des personnels de santé concernés et objectifs de régulation pour les autorités publiques» ».

La journaliste relève que « les concepteurs d’IA médicales n’ont que peu de comptes à rendre sur leurs produits. En France, précisent les auteurs de l’avis, ces dispositifs médicaux sont évalués par la Haute Autorité de santé lorsqu’ils ont vocation à être pris en charge par l’Assurance-maladie ».

Ils écrivent ainsi que « la presque totalité des algorithmes utilisés par les professionnels de santé se voient donc exclus de l’évaluation par la HAS puisqu’ils n’ont pour la plupart pas vocation à être vendus aux patients ».

Soline Roy poursuit : « Faut-il élargir le périmètre de la HAS ? Et sur quels critères évaluer ces nouveaux «systèmes très singuliers comparativement à, par exemple, un abaisse-langue ou des béquilles» ? Les risques de biais sont nombreux, à commencer par le choix des bases de données sur lesquelles sont entraînés ces programmes informatiques, lesquelles doivent donc être «elles-mêmes évaluées» ».

La journaliste relève que « l’une des règles d’or édictées par les membres du CNPEN et du CCNE est celle de «l’explicabilité» : un médecin doit toujours pouvoir expliquer ce que l’IA a découvert ou suggéré. Ces «décisions» doivent aussi toujours pouvoir être questionnées : il ne faut pas «se priver des avantages apportés par ces outils», mais se donner «constamment les moyens de prendre de la distance avec le résultat fourni» ».

Soline Roy s’interroge : « La machine totalement autonome existera-t-elle ? «Il faudra redéfinir le rôle et la responsabilité de l’expert», juge Philippe Moingeon, spécialiste de l’utilisation de l’IA pour le développement de médicaments. Mais de nombreux experts parient encore sur une longue supériorité de l’intelligence humaine ».

La Croix remarque de son côté : « Intelligence artificielle dans la santé, la prudence du comité d’éthique ».

Le journal retient ainsi que « l’intelligence artificielle utilisée pour le diagnostic médical ouvre des perspectives majeures, par exemple en permettant d’identifier des microlésions échappant à l’œil humain sur des radiographies, ou encore en permettant aux médecins de surveiller en continu les indicateurs biologiques des patients à domicile ».

Le quotidien ajoute qu’« elle ne saurait être utilisée «dans une logique de substitution à l’intervention humaine», insistent le Comité consultatif national d’éthique (CCNE) et le Comité national pilote d’éthique du numérique (CNPEN) ».

La Croix note que « l’algorithme peut en effet commettre des erreurs – aussi bien des faux négatifs (une lésion ou une anomalie lui échappe) que des faux positifs (il identifie des lésions qui n’en sont pas en réalité). Plus largement, ces outils «peuvent être binaires lorsqu’ils ne sont pas utilisés avec un regard critique» ».

« Le «contrôle humain à toutes les étapes du soin» fait ainsi partie des 16 recommandations émises par cet avis, qui compte du reste 7 points de vigilance. Parmi eux, le risque qu’il y a à considérer ces systèmes numériques comme «des solutions de substitutions des équipes médicales», dans un contexte de raréfaction des ressources hospitalières », souligne le journal.

Quelle éthique pour l’utilisation de l’intelligence artificielle dans la santé?

Par Soline Roy

Publié il y a 9 heures

DÉCRYPTAGE – Le Comité national d’éthique publie un avis sur les questions posées par l’utilisation de l’IA pour le diagnostic médical.

Identifier en un éclair un AVC sur un scanner cérébral. Prévoir le risque suicidaire en analysant des conversations sur un réseau social. Déceler une maladie de Parkinson débutante grâce à un changement de démarche. Dépister un cancer du poumon à un stade ultra-précoce…

Les promesses de l’intelligence artificielle (IA) sont nombreuses, et elle en remplit déjà beaucoup à toutes les étapes du soin, de la conception des médicaments au suivi post-traitement en passant par le dépistage et le diagnostic. Mais à l’aube d’une révolution médicale qui nous propose de mettre notre santé aux mains des machines, les questions soulevées sont nombreuses. Et en particulier les questions éthiques.

À lire aussiUne IA pour mieux prédire les comportements suicidaires chez les étudiants

Le Comité national pilote d’éthique du numérique (CNPEN), sous l’égide du Comité consultatif national d’éthique (CCNE), rend public ce mardi un avis sur les enjeux liés à l’utilisation de l’intelligence artificielle dans le domaine du diagnostic médical. Des enjeux «hétérogènes, voire parfois contradictoires, alertent…

Cet article est réservé aux abonnés. Il vous reste 75% à découvrir.

Intelligence artificielle dans la santé, la prudence du comité d’éthique

Les faits

Dans un avis commun adopté fin novembre et rendu public ce mardi 10 janvier, le Comité consultatif national d’éthique (CCNE) et le Comité national pilote d’éthique du numérique (CNPEN) soulignent les « tensions éthiques » que posent les systèmes d’intelligence artificielle pour le diagnostic médical.

- Mélinée Le Priol,

- le 10/01/2023 à 06:11 https://www.la-croix.com/Sciences-et-ethique/Intelligence-artificielle-sante-prudence-comite-dethique-2023-01-10-1201249963

L’intelligence artificielle utilisée pour le diagnostic médical ouvre des perspectives majeures, par exemple en permettant d’identifier des microlésions échappant à l’œil humain sur des radiographies, ou encore en permettant aux médecins de surveiller en continu les indicateurs biologiques des patients à domicile. Mais elle ne saurait être utilisée « dans une logique de substitution à l’intervention humaine », insistent le Comité consultatif national d’éthique (CCNE) et le Comité national pilote d’éthique du numérique (CNPEN), dans un avis commun rendu public ce mardi 10 janvier.

À lire aussiLes espoirs thérapeutiques de l’intelligence artificielle

Celui-ci avait été demandé par le premier ministre dans une lettre datée du 15 juillet 2019. La thématique des systèmes d’intelligence artificielle pour le diagnostic médical (SIADM) relevant autant de la bioéthique que de l’éthique du numérique, les deux instances ont conduit une réflexion commune, après avoir auditionné une dizaine d’experts du sujet. Conformément à la saisine ministérielle, elles n’ont pas abordé la question de la prévention ni des traitements, mais seulement celle du diagnostic médical. Si l’avis n’a été rendu public que ce 10 janvier, il avait été adopté dès le 23 et le 24 novembre derniers respectivement par le CNPEN et le CCNE.

Un nécessaire regard critique

« Un SIADM, s’il peut rassurer par son fonctionnement rigoureux et automatique, ne plonge pas moins le patient comme l’équipe soignante dans un certain degré d’incertitude », lit-on dans ce document. L’algorithme peut en effet commettre des erreurs – aussi bien des faux négatifs (une lésion ou une anomalie lui échappe) que des faux positifs (il identifie des lésions qui n’en sont pas en réalité). Plus largement, ces outils « peuvent être binaires lorsqu’ils ne sont pas utilisés avec un regard critique ».

À lire aussi « L’intelligence artificielle doit rester un outil au service des médecins »

Le « contrôle humain à toutes les étapes du soin » fait ainsi partie des seize recommandations émises par cet avis, qui compte du reste sept points de vigilance. Parmi eux, le risque qu’il y a à considérer ces systèmes numériques comme « des solutions de substitutions des équipes médicales », dans un contexte de raréfaction des ressources hospitalières.

L’intelligence artificielle promet en effet de précieux gains de temps. En accomplissant des tâches répétitives, elle pourrait permettre aux médecins d’échanger davantage avec leurs patients, et de traiter des situations plus complexes. Mais l’avis du CCNE et du CNPEN estime que la technologie ne doit pas être « un moyen de pallier l’organisation déficiente » du système de santé. « Les obstacles à l’accès aux soins ne peuvent être supprimés par les seuls outils numériques dont l’appropriation par les patients est inégale », précise le document.

Quatrième avis pour le CNPEN

Autre danger : l’approfondissement de la distance entre des médecins plus ou moins familiers du numérique et entre les professionnels de la santé et de l’intelligence artificielle d’une part, et les patients d’autre part. L’avis recommande donc de promouvoir un nouveau statut : celui d’auxiliaire – ou d’aidant – numérique, qui aiderait les patients à mieux comprendre les résultats produits par l’intelligence artificielle.

À lire aussi Des propositions pour encadrer l’intelligence artificielle dans la santé

Comment l’intelligence artificielle bouscule les pratiques médicales

Par Laure BelotPublié aujourd’hui à 06h00, mis à jour à 09h23

Temps de Lecture 11 min.

Enquête

Des algorithmes commencent à être utilisés en routine en France, par exemple en radiologie, afin notamment d’aider le médecin dans son diagnostic. Pourtant, institutions de soin et de recherche tâtonnent pour évaluer et diffuser cette technologie prometteuse.

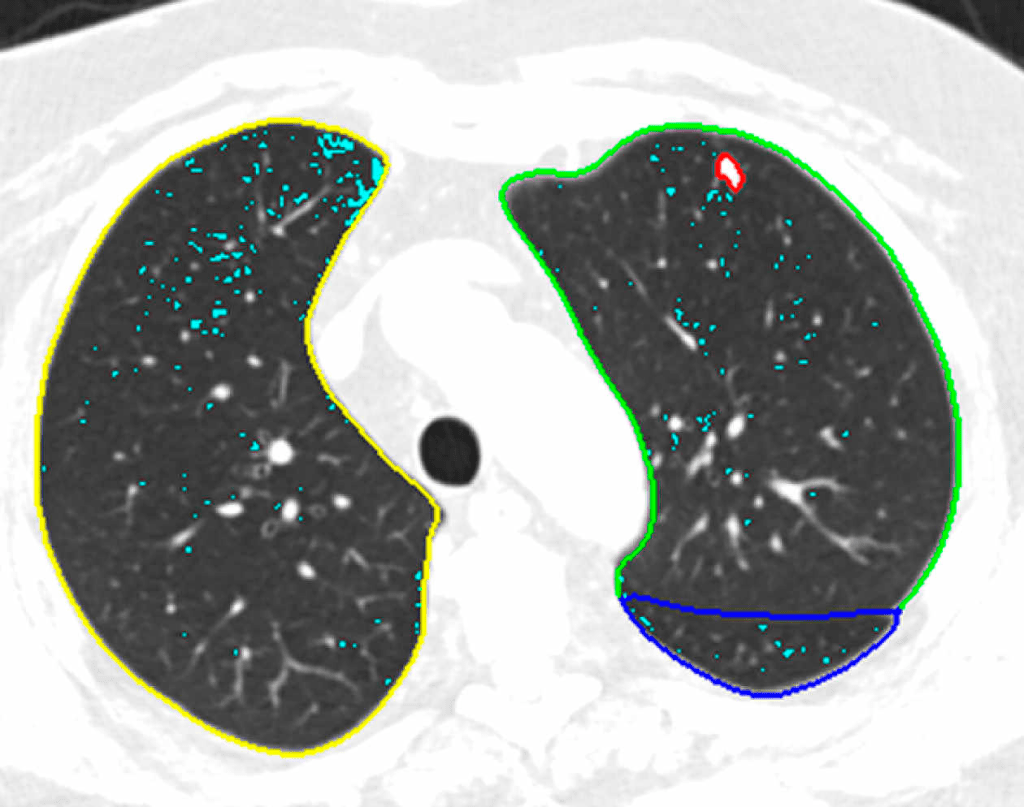

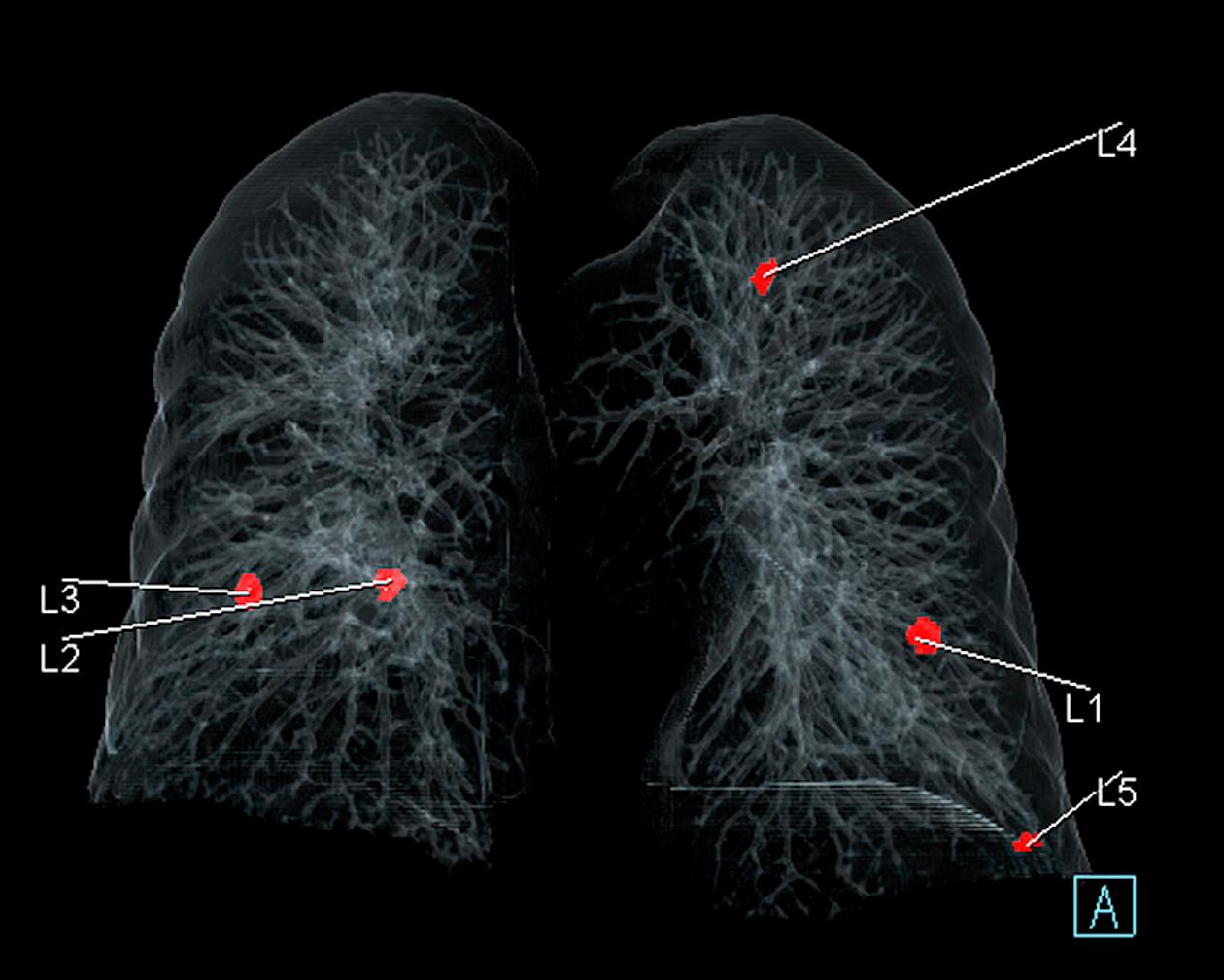

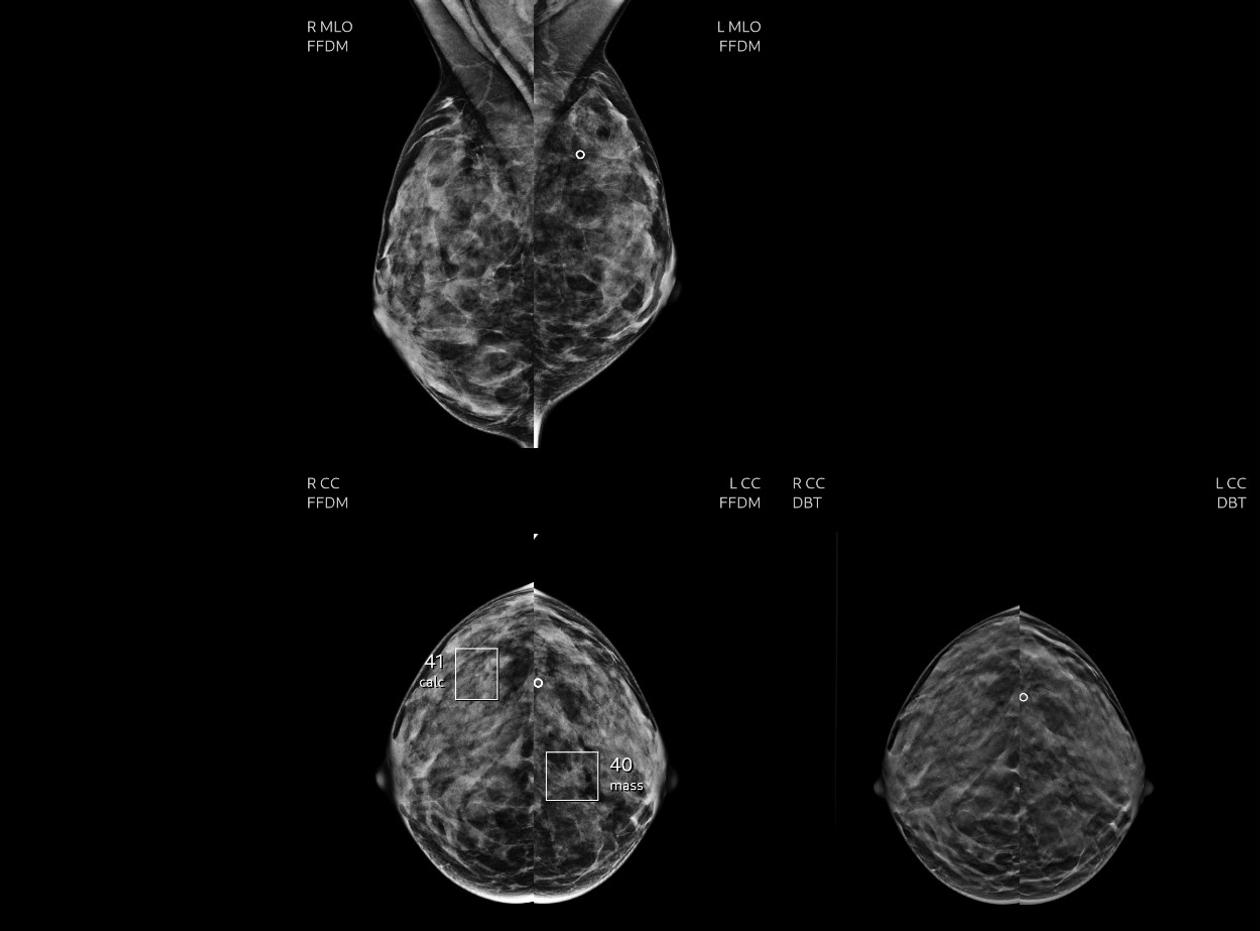

Détection de nodules pulmonaires cancéreux par l’IA au scanner, à l’hôpital Foch. HOPITAL FOCH

Le 27 octobre 2016 à Toronto (Canada), Geoffrey Hinton, un des pères de l’intelligence artificielle (IA) moderne, affirmait en substance qu’il fallait cesser de former des radiologues, car les algorithmes les auraient dépassés avant cinq ans ! Six ans plus tard, les radiologues pratiquent toujours, et l’enthousiasme court-termiste autour du machine learning (« apprentissage machine ») a laissé place à plus de mesure.

« Les promesses sont nombreuses et on peine parfois à les distinguer des faits », constatent ainsi, mardi 10 janvier, le Comité consultatif national d’éthique (CCNE) et le Comité national pilote d’éthique du numérique (CNPEN), dans leur avis commun. Publié sous le titre « Diagnostic médical et intelligence artificielle : enjeux éthiques », il rassemble seize recommandations et sept points de vigilance. Où en est concrètement l’utilisation de l’IA, annoncée comme une des révolutions médicales de ce siècle ? Où en est l’exploitation de cette quantité astronomique de données numérisées (textes, images et chiffres) appelée à entraîner des algorithmes dans le but d’aider au diagnostic et au choix thérapeutique ?

Au Congrès européen de radiologie, qui s’est tenu à Vienne, en juillet 2022, Emily Conant, professeure de radiologie à l’hôpital de l’université de Pennsylvanie, a « appelé à la prudence, relate Isabelle Thomassin, cheffe de service en imagerie médicale à l’hôpital Tenon (AP-HP, Sorbonne Université). L’IA est une opportunité, nous en sommes sûrs, mais il faut l’utiliser correctement. »

L’analyse d’images médicales (radiographies conventionnelles, mammographies…) est pour l’instant la première utilisation concrète de l’IA dans le monde, mais « une récente revue systématique a montré qu’en mammographie, par exemple, des biais méthodologiques existaient dans la plupart des études scientifiques », explique la radiologue française. Comme celle de Google Health en 2020, pourtant publiée dans la prestigieuse revue Nature, selon laquelle la machine seule dopée par l’IA faisait mieux qu’un radiologue. « Le logiciel avait été entraîné sur une population de femmes dont les seins étaient beaucoup plus porteurs de cancer qu’une population générale », explique la spécialiste.« Or, c’est bien plus simple statistiquement pour un logiciel, quand il y a beaucoup de cancers, de dire “c’est un cancer”, que quand il y en a peu. » Les performances des algorithmes peuvent aussi dépendre de la provenance géographique des images qui les ont entraînés. « Les seins des Japonaises sont très denses, alors que ceux des Européennes du Nord, appelés “seins clairs”, ont plus de graisse et sont plus faciles à lire », illustre cette experte.

« Nous avons déjà été échaudés il y a trente ans avec le CAD [Computer Aid Detection, « aide au diagnostic »], se souvient Isabelle Thomassin. On annonçait que l’informatique allait remplacer le radiologue avec ce système basé non sur du machine learning mais sur de la segmentation [détection géométrique de lésions]. Très vite, les Américains l’ont remboursé, avant de revenir sur leur décision, dix ans plus tard, car il y avait trop de faux positifs [machine trop sensible] et beaucoup trop de biopsies faites pour rien. »

Les dernières études scientifiques, telle celle publiée dans The Lancet Digital Health en juillet 2022, démontrent qu’une IA et un praticien font mieux qu’un praticien seul pour lire une mammographie. « Le projet de remplacement du radiologue est en passe d’être abandonné, résume Isabelle Thomassin. On évoque deux pistes d’utilisation future : l’amélioration du quotidien pour le radiologue, et une fonction de triage de l’IA. Certaines mammographies pourraient être identifiées comme normales par un algorithme, et la compétence et le temps du radiologue seraient consacrés à des cas plus complexes. »

Aide au diagnostic

En France, un site de l’Agence nationale d’appui à la performance sanitaire, mis en ligne le 1er avril 2022, recense l’utilisation clinique de l’IA sous trois rubriques : diagnostic, aide à la décision et médecine préventive et prédictive. Ce sont pour l’instant des usages en routine pour l’aide au diagnostic qui émergent sur le territoire.

A Strasbourg, au service d’imagerie de la femme de l’hôpital universitaire, l’équipe médicale utilise quotidiennement, depuis septembre 2022, une IA en seconde lecture pour les mammographies, « après l’avoir testée deux ans avec nos propres données », précise le radiologue Sébastien Molière. « Nous procédons à l’examen clinique, et prévenons les patientes qu’après la mammographie une lecture va être faite par un logiciel. Cela n’a jusqu’à présent pas soulevé de problème. » L’IA, élaborée par une start-up, alerte « plus qu’il ne faudrait et nous continuons à l’évaluer », remarque Sébastien Molière. Mais, sur quatre mois d’utilisation, à raison d’une trentaine de mammographies par jour, l’outil a permis à trois reprises d’identifier des microcalcifications, signes potentiels de précancer, qui n’avaient pas été identifiées par l’œil du praticien. Après biopsie, l’une d’elles s’est révélée cancéreuse. « L’IA va être très utile pour des professionnels sans beaucoup d’expérience, estime-t-il. Le praticien n’est jamais dans le blanc ou le noir quand il lit un cliché, alors que sa réponse doit être binaire pour le patient. C’est un outil qui peut apporter de l’assurance », précise le radiologue.

A Suresnes (Hauts-de-Seine), au service des urgences, c’est par la radio du thorax, des pieds et des mains que l’hôpital Foch a commencé à utiliser l’IA en pleine pandémie, début 2021, pour identifier des lésions après traumatisme. Après deux ans d’application en routine, le chef de service de la radiologie, François Mellot, voit l’IA « comme un compagnonnage : super reproductible, elle ne se fatigue pas, n’a pas de mal à se réveiller et ne se laisse pas distraire ». Pour l’instant, reconnaît-il, « nous n’avons pas encore une adhésion totale des urgentistes. Les algorithmes sont trop sensibles, le taux de faux positifs est de l’ordre de 15 % à 20 %, et ça peut lasser. »

Cela n’empêche cependant pas l’hôpital de continuer sa politique volontariste. L’IA est utilisée pour dépister les nodules pulmonaires depuis 2021 et en mammographie depuis janvier 2022. Un logiciel pour détecter l’embolie pulmonaire est actuellement en évaluation. « Nous sommes sur la courbe dite “de Gardner” : toute révolution technologique connaît, dans son utilisation, une période d’euphorie, une pente de la désillusion, avant de trouver un niveau asymptotique correct d’utilisation. Nous sommes dans une certaine désillusion, mais cela va évoluer. Entre-temps, nous devons nous approprier ces outils, nous acculturer pour bien inclure cette brique dans le work flow [“flux de travail”] », affirme-t-il.

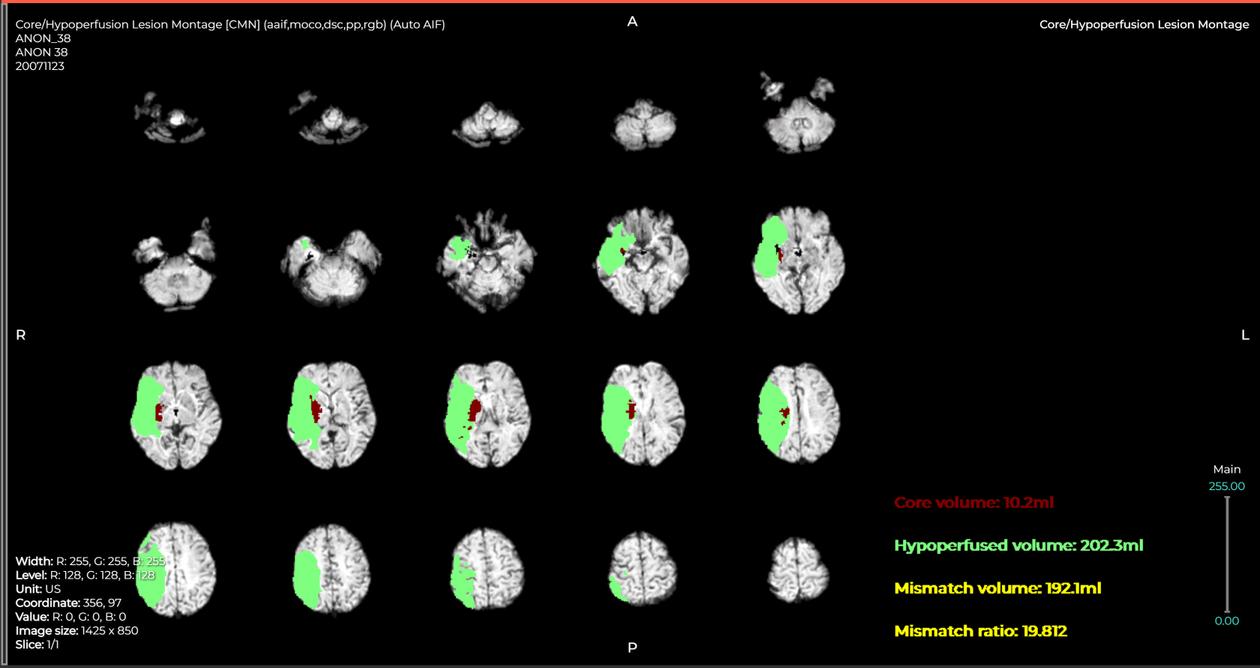

A l’hôpital de Garches (Hauts-de-Seine), c’est à la faveur de l’ouverture de l’unité neurovasculaire qu’un logiciel d’IA est utilisé depuis septembre 2021 pour « quantifier le volume de cerveau touché lors d’un accident vasculaire cérébral [AVC] ischémique [à la suite d’un caillot] », détaille la professeure en neuroradiologie Myriam Edjlali-Goujon : « Nous utilisons l’algorithme après l’IRM et avant la prise de décision humaine. Cette information identifie la zone du cerveau perdue et celle en pénombre, mise en hibernation, potentiellement “sauvable” si on agit vite. »

Habituellement, ce travail de volumétrie « long et fastidieux est fait manuellement, mais time is brain [“le temps, c’est du cerveau”] », explique-t-elle : « Après un an de vérification de reproductibilité des résultats, le logiciel apporte une vraie qualité de réponse. » L’avantage ? « Cela nous permet de fonctionner de façon fiable vingt-quatre heures sur vingt-quatre, sept jours sur sept. » Une approche algorithmique similaire appliquée à 111 000 patients au Royaume-Uni a permis de tripler (48 % contre 16 %) la part des personnes « récupérant sans handicap ou avec un handicap minime »après un AVC, a affirmé, dans un communiqué du 27 décembre 2022, le département de la santé et des affaires sociales britannique.

Eviter les erreurs

Il se dessine « deux grands types d’utilisations de l’IA », analyse l’oncologue Alain Livartowski, conseiller médical d’Unicancer et spécialiste des données. Pour lui, celle illustrée par les exemples ci-dessus « ne remplacera pas l’humain mais l’aidera à aller plus vite ou à éviter les erreurs. L’IA fera a priori aussi bien que les spécialistes du domaine ». Une approche qui peut notamment aider à diminuer l’inégalité des soins sur un territoire et augmenter l’expertise de radiologues polyvalents.

« Et puis, poursuit-il, il y a l’IA que l’on espère tous, celle de la disruption, qui fera des choses que les médecins ne savent pas ou ne pourront pas faire », en brassant notamment énormément de données pour, in fine, influencer les traitements. Dans cette optique d’aide à la décision thérapeutique, certaines solutions affleurent en France. A partir des données de l’institut Gustave-Roussy, un algorithme qui prédit pour une personne atteinte d’un cancer du sein précoce la probabilité de rechuter après le traitement (basé sur la lecture de lames histologiques au microscope) vient d’obtenir une certification européenne.

D’autres usages sont déjà en routine. Depuis décembre 2021, à l’institut Curie, un algorithme d’IA couplé à des analyses biologiques de tumeurs « permet d’identifier l’organe responsable d’un cancer métastasé d’origine inconnue et d’adapter en connaissance le traitement », explique la chercheuse et oncologue Sarah Watson. Environ 70 personnes en France ont pu bénéficier de cette approche.

Lire aussi : Quand l’intelligence artificielle permet d’identifier l’origine inconnue d’un cancer métastasé

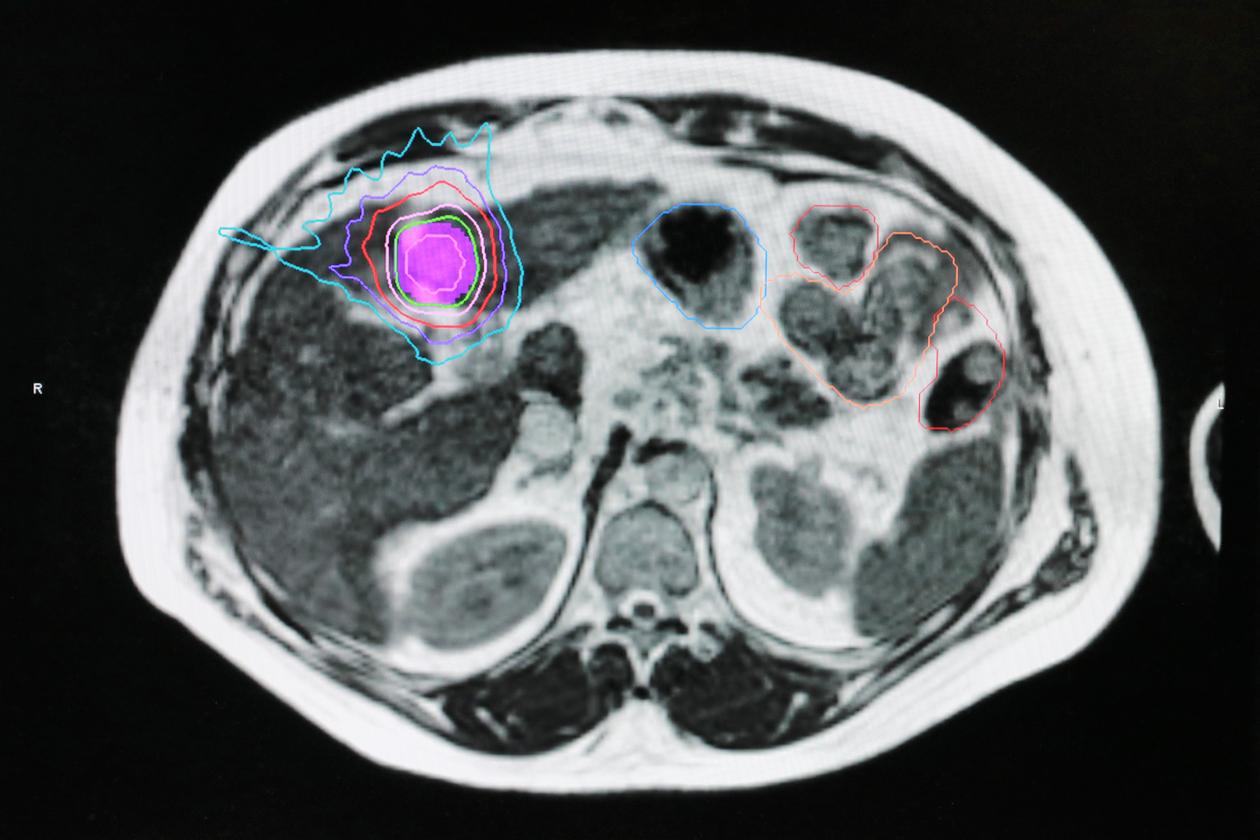

L’Institut régional du cancer de Montpellier (ICM) propose, lui, depuis fin 2020, un logiciel d’IA qui recalcule, dans le cas d’une radiothérapie guidée par scanner, le protocole à suivre en fonction de l’évolution de la tumeur. Cet algorithme « permet, en cours de traitement, de réduire la zone irradiée et de protéger les tissus sains si la tumeur a diminué », relève le professeur David Azria, directeur scientifique de l’ICM. « Tout est encore perfectible, et je ne crois pas au logiciel providentiel mais, dans ce cas précis, l’IA n’est pas seulement une aide au diagnostic, c’est aussi une aide à la thérapeutique », note l’oncologue, également président de la Société française de radiothérapie oncologique (SFRO).

L’ICM et l’hôpital d’Herlev, au Danemark – tous deux pionniers mondiaux dans l’utilisation de ce dispositif –, travaillent main dans la main pour aller plus vite dans l’étude clinique, encore en cours. Montpellier s’est focalisé sur les cancers gynécologiques et de la vessie, Herlev sur ceux de la prostate.

Autre innovation utilisant de l’IA dans l’Hérault, mais sur une autre machine, « une radiothérapie guidée par l’IRM permet de cibler des tumeurs du foie ou du pancréas, organes dont on établit les contours et que l’on suit ainsi mieux ». Le service de radiothérapie des hôpitaux parisiens de la Pitié-Salpêtrière et Tenon sont venus se former sur ces applications à Montpellier.

Ces exemples ne doivent cependant pas masquer la réalité d’une diffusion très parcimonieuse de ces d’outils. « Des avancées technologiques existent désormais, mais les adoptions par les centres de soins, très faibles, ne sont pour l’instant pas à la hauteur des attentes », analyse le chercheur Nikos Paragios, fondateur de la start-up TheraPanacea, qui a conçu la solution d’IA pour le traitement guidé par IRM à Montpellier.

Ce mathématicien, dont l’entreprise est un spin-off de l’université Paris Saclay et de l’institut Gustave-Roussy, voit trois raisons à la morosité, qu’il juge mondiale, du marché de l’IA médicale. Tout d’abord, « il n’existe pour l’instant pas vraiment de modèle économique, car les algorithmes d’IA ne sont pas remboursés », explique-t-il. « Les médecins sont frileux par rapport à ces solutions algorithmiques, souvent des boîtes noires non explicables, même si la jeune génération semble plus ouverte », poursuit-il. Enfin, « aucune application phénoménale améliorant drastiquement le work flow dans les centres de soins n’a jusqu’à présent été trouvée ».

De fait, la rapidité de développement des solutions d’IA bouscule le système médical. « S’il faut attendre que ce soit remboursé, personne ne fera rien, lance le professeur David Azria. On nous demande en France de prouver l’efficacité de ces approches. Or, pour l’instant, nous sommes en plein programme de recherche. Ces soins sont en routine, certes, mais avec des études cliniques associées et le consentement éclairé des patients. » Le responsable de la SFRO conçoit que, pour les établissements, la décision d’investir dans des solutions d’IA soit compliquée à prendre. « Ces études cliniques de radiothérapie prennent du temps de machine, elles sont pour l’instant gourmandes en ressources humaines et avides en financement. L’IA asservie au scanner fait par exemple doubler le prix d’une machine qui atteint 3,6 millions d’euros. »

Solution économiquement fragile

Pour l’usage en radiologie, plus étendu sur le territoire, les centres privés qui se sont dotés de solutions d’IA peuvent faire des dépassements d’honoraires pour financer le service, payé environ 1 euro par cliché aux start-up éditrices de logiciels. Certains centres publics nouent, eux, des « partenariats » : ils bénéficient gracieusement des algorithmes, en échange de leur expertise médicale pour évaluer ces logiciels. « C’est une solution économiquement fragile » , reconnaît Isabelle Thomassin, qui, à l’hôpital Tenon, utilise ce type de partenariat depuis deux ans pour la lecture de mammographies. Pour le sein, ajoute-t-elle, « l’ensemble des établissements de l’AP-HP prépare une base de données commune française pour entraîner les logiciels testés ».

Alors que « beaucoup de solutions d’IA sont proposées sans performances cliniques validées en France », continue Isabelle Thomassin, une initiative, Drim France IA, a été lancée par le Conseil national professionnel de la radiologie (qui rassemble radiologues libéraux, universitaires, hospitaliers et sociétés savantes) afin de clarifier la situation et d’aider les radiologues à s’y retrouver. Cette association de loi 1901 a sollicité les start-up éditrices afin de « répondre à une grille analytique et descriptive de leurs solutions pour les aides au diagnostic de cancer du sein, de fractures osseuses et de nodules pulmonaires, qui constituent la majorité des logiciels proposés sur le marché français ». Des démarches similaires, portées respectivement par l’American College of Radiology et la Canadian Association of Radiologists sont en cours aux Etats-Unis et au Canada.

La validation clinique de l’intelligence artificielle demeure une question centrale, note Fabrice André, directeur de la recherche de l’institut Gustave-Roussy. « Quel niveau de preuve scientifique est suffisant pour considérer que le test est valide ? Combien de recherches cliniques sont nécessaires ? Les études rétrospectives sont-elles suffisantes ? Ce sont souvent les sociétés savantes qui déterminent cela, mais, pour l’instant, ce n’est pas extrêmement clair dans le domaine de l’IA », note-t-il.

La situation est d’autant plus floue, souligne l’avis des CCNE et CNPEN, que « presque la totalité des algorithmes utilisés par les professionnels de santé se voient exclus de l’évaluation par la Haute Autorité de santé, car ils n’ont, pour la plupart, pas vocation à être vendus aux patients ». Ce défaut d’évaluation, poursuit le texte, « est susceptible d’entraver légitimement la confiance ». Un encadrement « reste donc à construire », précise l’avis, l’évaluation clinique devant tout autant montrer « l’absence de nocivité » du système d’IA que sa « bienfaisance ». Concernant la question centrale du financement, les deux comités recommandent d’« engager une concertation nationale » et d’inscrire dans le projet de loi de financement de la Sécurité sociale « une section consacrée au financement de l’IA ».

Autre bouleversement, cette nouvelle technologie fait se côtoyer des univers parfois très éloignés, notamment en France : centres de recherche et de soins, start-up, grands groupes industriels et informatiques. L’IA « constitue un défi collaboratif », résume le professeur David Azria. « Le recours à l’intelligence artificielle va faire tomber les barrières pour des convergences rapides, pronostique-t-il. Ceux qui veulent garder leurs barrières vont rester seuls. Le train est en train de passer. »

A Gustave-Roussy, Fabrice André prône les collaborations public-privé pour une meilleure efficacité. « Il est illusoire de penser qu’un hôpital ou un centre de soins puisse maîtriser la chaîne de A à Z. Il faut travailler avec les meilleures entreprises à qui nous puissions transférer le savoir de nos pathologistes, médecins, biologistes, nos spécialistes en technologie. L’important, c’est que le soin puisse arriver au patient. »

L’hôpital Trousseau (AP-HP Sorbonne Université) en fait actuellement l’expérience avec le projet européen SUOG(Smart Ultrasound in Obstetrics and Gynecology). Plus d’une centaine de milliers de clichés de fœtus (2D, 3D…) ont été rassemblés par un consortium de dix centres d’imagerie (France, Espagne, Royaume-Uni, Belgique) pour entraîner un algorithme de machine learning. Objectif ? « Guider l’échographiste pas à pas pour lui montrer les bonnes images afin de caractériser des aspects inhabituels du fœtus », précise le gynécologue obstétricien Ferdinand Dhombres, responsable du projet. Un partenariat académique et industriel a été conclu avec le groupe General Electric Healthcare qui doit intégrer l’algorithme dans un appareil d’ici à fin 2023. « Au départ, je n’y étais pas favorable, c’était un peu comme vendre son âme au diable, reconnaît-il. Mais les industriels font tout ce que nous ne savons pas faire et l’expérience est fructueuse. Si on développe des solutions de diagnostic, c’est avant tout pour que cela puisse servir au plus grand nombre. »

Un appel à des recherches plus fiables

Prédiction de risques d’un AVC par la recherche de troubles du rythme à l’électrocardiogramme, détection précoce de la maladie d’Alzheimer par des modifications de la voix ou de la maladie de Parkinson par l’analyse de la respiration, etc. Tandis que le nombre de recherches alliant intelligence artificielle (IA) et médecine prédictive est en croissance exponentielle partout dans le monde, une équipe internationale de médecins (Pays-Bas, Singapour, Royaume-Uni) vient d’appeler à la prudence, dans Nature Médecine, pour ne pas décrédibiliser l’IA avant même qu’elle ne soit appliquée. Ces chercheurs soulignent en substance que l’IA ne sera pas une réponse universelleen médecine et notent que nombre de bases de données utilisées en recherche ne sont pas assez conséquentes pour être fiables. « Des entreprises ont entraîné avec succès des algorithmes pour reconnaître des visages et des véhicules à partir de milliards d’images et de vidéos. Mais lorsqu’il s’agit de les utiliser dans le cadre des soins de santé, ces algorithmes sont souvent entraînés sur des données par dizaines, centaines ou milliers », expliquent les auteurs, qui déclarent travailler à l’organisation d’un effort international pour mettre en place une grande base de données cliniques anonyme.

L’intelligence artificielle peut constituer une aide précieuse au diagnostic médical mais…

Par Louise Claereboudt le 10-01-2023

Dans un avis publié ce mardi 10 janvier, deux comités d’éthique estiment que les systèmes d’intelligence artificielle utilisés pour le diagnostic médical peuvent constituer une aide précieuse pour les soignants. Mais un contrôle humain doit être introduit à chaque étape de leur conception et de leur utilisation.

Alors que les systèmes d’intelligence artificielle utilisés pour le diagnostic médical irriguent désormais tout le champ de la pratique médicale, le Comité national pilote d’éthique du numérique (CNPEN) et le Comité consultatif national d’éthique pour les sciences de la vie et de la santé ont été saisis en juillet 2019 par le Premier ministre pour identifier les enjeux éthiques de leur utilisation. En résultent 16 recommandations et 7 points de vigilance.

« Le numérique et en particulier l’intelligence artificielle en santé ouvrent des perspectives majeures de transformation de notre système de santé avec des capacités de renforcement significatif de la qualité des diagnostics et des soins au service des patients », estiment les instances dans un communiqué commun, joint à leur avis, rendu public ce mardi. A l’instar de la détection de lésions invisibles à l’œil, illustrent-elles. Ces IA « permettent de traiter très rapidement des cas assez aisés à diagnostiquer mais répétitifs, et libèrent ainsi du temps médical pour échanger avec le patient ».

Toutefois, ces outils engendrent une transformation majeure de la relation soignants-patients mais aussi de l’organisation des soins. Si les systèmes d’intelligence artificielle utilisés pour le diagnostic médical peuvent aider à générer des résultats ou établir des prédictions et des recommandations, ces « résultats » sont « basés d’une part sur des approches probabilistes et d’autre part qu’ils peuvent être entachés d’erreurs », rappellent les deux comités.

« S’il ne serait pas éthique que les équipes soignantes et les patients se privent des avantages apportés pas ces outils, il faut se donner constamment les moyens de prendre de la distance avec le résultat fourni et il est indispensable de créer les conditions de la confiance », estiment le CCNE et le CNPEN. Ainsi, tout système d’intelligence artificielle utilisé pour le diagnostic médical « doit être soumis à un contrôle humain », recommandent-ils. « Ses résultats doivent être explicables. »

Le contrôle de conformité du système d’IA, « qui assure qu’il n’est pas dangereux et ainsi autorise sa mise sur le marché, doit être amélioré et surtout doit à l’avenir être accompagné d’une évaluation de son efficacité clinique montrant non seulement son absence de nocivité mais aussi qu’il contribue efficacement au principe de bienfaisance », peut-on lire dans l’avis.

Par ailleurs, ces outils doivent toujours « être utilisés en priorité dans une optique d’amélioration du soin, avant les intérêts organisationnels, économiques, ou managériaux », ajoutent les instances. Celles-ci observent en effet que les systèmes d’intelligence artificielle en santé s’accompagnent « d’enjeux hétérogènes voire parfois contradictoires, entre intérêts économiques et industriels (conception des outils de SIA), promesses thérapeutiques pour les patients (bénéfices sanitaires attendus, dépistage, prévention et traitement), modification de la pratique professionnelle des personnels de santé concernés (activité des soignants pouvant être amenés à les utiliser, aide au diagnostic, éventuellement même des suppressions ou modifications de postes) et objectifs de régulation pour les autorités publiques ».

Les deux comités appellent ainsi à placer au premier rang des valeurs le « respect de la vie humaine » et « la garantie de conditions équitables d’accès aux soins ».